インストールする先

ここでは、一般的にサーバーとしてよく利用されるであろうLinuxにインストールします。また、Driverless AIの売りの一つである、NVidia GPUを持つサーバーを使います。

事前準備

NVidia GPUのドライバーをインストール(手順は省略)

Dockerをインストール(手順は省略)

インストーラーの入手

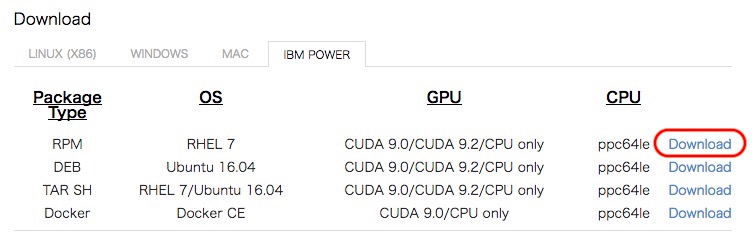

PCを使って以下のURLから、Driverless AIのインストーラーを入手します。ここでは、Redhat版としました。Direct Downloadsというところです。あと、当方のサーバーはIBM Powerなので、そちらを選択しています。

https://www.h2o.ai/download/

これをサーバーにアップロードしておきます。

Dockerコンテナーを起動(GPU付き)

次のコマンドで、Dockerコンテナーを起動します。

nvidia-docker run --privileged=true --shm-size=512m --name driverless_ai_server1 -v /home/user1:/home/user1 -d -p 12345:12345 nvidia/cuda-ppc64le:9.0-cudnn7-devel-centos7 /sbin/init- priviledgedを指定することで、systemctlによるサービス起動ができる

- shm-size を指定しないと、Driverless AIの機械学習の実行時にFailすることがあった

- -vで、Linuxホスト側のディレクトリーをDockerコンテナーのディレクトリーにマップすることができるので、ここにインストーラーを置く

- -pで、外部に公開するポート番号(12345)を指定

- cudaコンテナーを使用することで、GPUが使える

Dockerコンテナーに入り、Driverless AIをインストールする

次のコマンドで、起動したコンテナーに入ります。

docker exec -it -e COLUMNS=$COLUMNS -e LINES=$LINES -e TERM=$TERM driverless_ai_server1 bashインストーラーを実行します。

cd /home/user1

rpm -i dai-1.3.1-1.ppc64le.rpm以上でインストールは完了です。初回はすでに起動していると思いますが、起動は以下のコマンドで行います。

systemctl start daiDriverless AIを使う

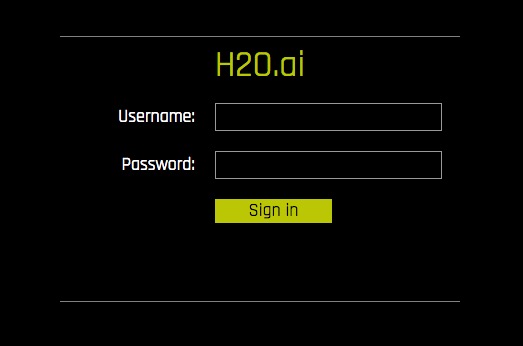

PCのWebブラウザから、次のURLでDriverless AIのGUIに接続できます。

http://server_hostname:12345/login当初は、ユーザー名とパスワードは任意でよいです。注意点としては、ユーザー名が異なると、見えるデータが異なります。今まであったデータが見えない!という場合は、ユーザー名を確認してください。

お疲れさまでした。

Start the discussion